Tytułowe pytanie zostało zadane przez jednego z uczestników webinaru nt generatywnej AI w zeszłym tygodniu. Pytanie ciekawe, bo dotyka kilku istotnych aspektów związanych z korzystaniem z AI – przede wszystkim ryzyka występowania błędów w generowanych treściach oraz problemu autorstwa treści tworzonych przy wsparciu AI.

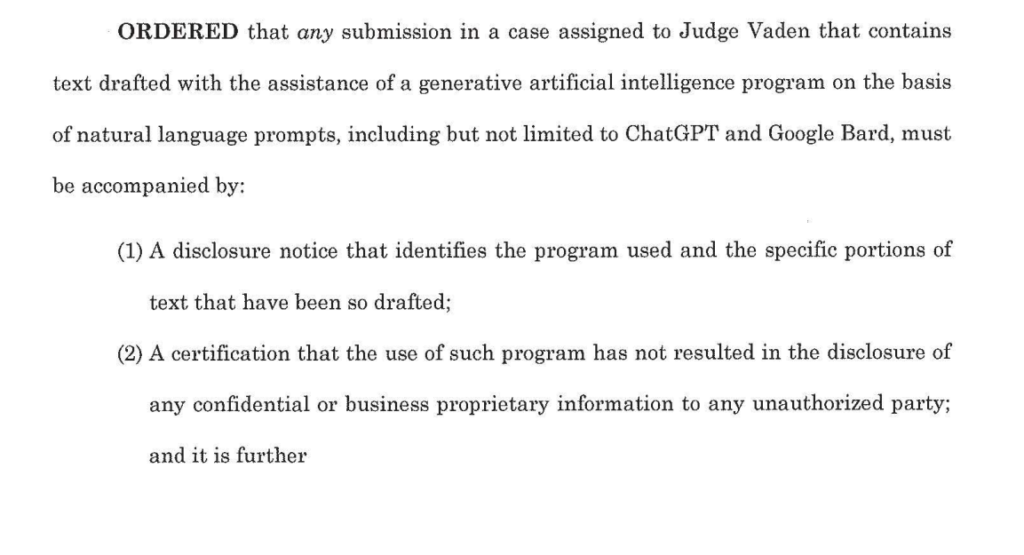

Amerykańskie sądy wymagają oświadczeń o AI

Zagadnienia te stały się ostatnio głośne za sprawą nowojorskiego adwokata, który złożył pismo procesowe powołujące się na szereg nieistniejących orzeczeń sądowych, wygenerowanych z użyciem ChatGPT i nie poddanych jakiejkolwiek weryfikacji. Okazuje się, że takich przypadków jest więcej i to nie tylko w Ameryce.

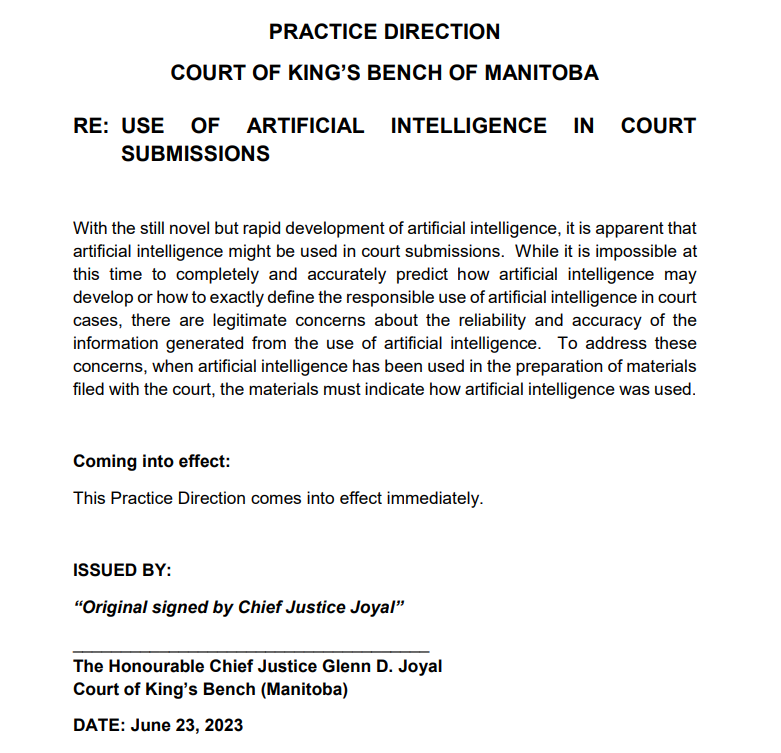

W konsekwencji niektóre sądy w USA i Kanadzie zaczęły wymagać od prawników, by ujawniali fakt korzystania z systemów AI do przygotowania pism procesowych oraz wskazywali, jak takie narzędzia były wykorzystywane oraz które fragmenty zostały wygenerowane przez system AI.

Niektóre sądy ograniczyły takie wymaganie do treści stworzonych z użyciem systemów generatywnej AI takich jak ChatGPT, inne wymagają, aby ujawniać użycie dowolnego systemu sztucznej inteligencji.

Poniżej dwa przykłady takich wymagań – pierwsze sędziego amerykańskiego Court of International Trade, drugiego zaś kanadyjskiego sądu w Manitobie.

Systemy AI a systemy generatywnej AI

Nie powinno się jednak stawiać znaku równości pomiędzy systemami generatywnej AI a innymi systemami sztucznej inteligencji z punktu widzenia oceny ryzyk związanych z ich działaniem.

Systemy AI mogą być bardzo różne, podobnie jak bardzo różne mogą być programy komputerowe. System AI może być zarówno samodzielnym programem jak i częścią innego systemu. Techniki programowania wykorzystujące sztuczną inteligencję rozpowszechniły się na tyle, że elementy AI można odnaleźć praktycznie w każdym oprogramowaniu, które wykorzystujemy na co dzień. Sztuczna inteligencja jest w wyszukiwarkach internetowych, w systemach rekomendacji produktów w sklepach internetowych, w asystentach głosowych, w systemie antyspamowym poczty elektronicznej, w programie do tłumaczeń czy w programie do wykrywania i korekty błędów językowych.

Specyficzną cechą systemów generatywnej AI, wyróżniającą je od innych systemów AI, jest to, że w ich działaniu występuje element losowości.

Oprogramowanie AI może działać w powtarzalny sposób, jeśli model wytrenowany na określonych danych nie jest aktualizowany ani modyfikowany w czasie rzeczywistym. Oznacza to, że taki model nie uczy się ani nie dostosowuje do nowych informacji, które mogą pojawić się po jego treningu. Jest to tzw. model statyczny AI. Taki system działa tak samo za każdym razem, o ile otrzymuje te same dane wejściowe. Jeśli podamy ten sam zestaw danych wejściowych dwukrotnie, system powinien zwrócić te same odpowiedzi.

Jednak w przypadku systemów generatywnej AI prawdopodobieństwo i losowość są fundamentami ich działania. W rezultacie nie da się do końca przewidzieć tego, jak taki system się zachowa po otrzymaniu określonych danych wejściowych.

Najprościej to pokazać na przykładzie systemów tekstowych takich jak ChatGPT. Działanie ich polega na analizowaniu podanego pytania (promptu), a następnie generowaniu odpowiedzi na tej podstawie. Modele te wykorzystują zbiory danych treningowych, aby nauczyć się wzorców językowych i kontekstowych zależności, które pomagają mu generować sensowne odpowiedzi.

Systemy te działają na zasadzie generacji sekwencji słów w oparciu o prawdopodobieństwo ich wystąpienia, przy czym odpowiedzi mogą być różne w zależności od podanego kontekstu i danych wejściowych.

Wbrew intuicji, wybranie słów o największym prawdopodobieństwie ich wystąpienia, najczęściej nie prowadzi do powstania interesującego tekstu. Dopiero zmniejszenie prawdopodobieństwa (i zarazem zwiększenie roli elementu losowości) sprawia, że ChatGPT daje lepsze rezultaty.

Więcej na ten temat w znakomitym artykule Stephana Wolframa „What Is ChatGPT Doing … and Why Does It Work?”, z którego także pochodzi powyższa ilustracja.

Co należy ujawniać?

Wymaganie, aby ujawniać samo skorzystanie z dowolnego systemu AI, jest nadmierne. Powszechność występowania tych systemów sprawia, że spełnienie tego wymagania byłoby zarówno kłopotliwe jak i niepotrzebne.

Czemu miałoby służyć ujawnienie skorzystania z wyszukiwarki internetowej, która wyświetla wyniki w oparciu o rekomendacje systemu AI? Albo sprawdzenie poprawności językowej tekstu przy pomocy systemu, który podpowiada poprawne formy gramatyczne lub zwroty?

Problem pojawia się dopiero przy systemach generatywnej AI. I na sposób korzystania z nich faktycznie warto zwrócić uwagę.

Trzy podstawowe wytyczne

Podstawowe zasady bezpiecznego (prawnie) korzystania z generatywnych systemów są proste. Można jest podsumować w trzech punktach – dwóch odnoszących się do danych wprowadzanych do systemu generatywnej AI (inputu, inaczej tzw. promptu) i jednego odnoszącego się do generowanych treści (outputu):

- Dane wprowadzane do systemu generatywnej AI powinny być anonimizowane.

- Dane wprowadzane do systemu generatywnej AI nie mogą zawierać danych objętych tajemnicą zawodową lub chronionych w inny sposób.

- Rezultaty działania systemu generatywnej AI muszą być zawsze weryfikowane przez człowieka.

Zasady te przywołuję w ślad za rekomendacjami dla radców prawnych dotyczących korzystania z systemów generatywnej AI przygotowanymi przez Komisja Legaltech przy OIRP w Warszawie („Jak korzystać z narzędzi generatywnej sztucznej inteligencji w pracy radców prawnych?” – Temidium z czerwca 2023 r.). Mają one charakter na tyle uniwersalny, że mogą być stosowane także poza sferą świadczenia usług prawnych.

Human in the loop

Łatwo zauważyć, że pierwsze dwie rekomendacje dotyczą w zasadzie każdego systemu informatycznego, w którym dostęp do danych może mieć inna osoba, czyli przede wszystkim systemów opartych na przetwarzaniu danych w chmurze. Są one zatem powtórzeniem zasad, który już obecnie powinny być elementarzem każdego użytkownika współczesnego oprogramowania, choć ryzyka związane z ich nieprzestrzeganiem ulegają wzmocnieniu w przypadku systemów generatywnej AI, gdyż systemy te wręcz zachęcają do wprowadzenia większej ilości danych – tylko wtedy wyniki ich działania będą bardziej kontekstowe i trafniejsze.

Dopiero rekomendacja trzecia jest ściśle związana ze specyfiką działania systemów generatywnej AI, czyli wspomnianą wyżej zasadą ich działania – generowania sekwencji słów opartych na prawdopodobieństwie ich wystąpienia, co może prowadzić do wytworzenia treści zawierających nieprawdziwe informacje.

I tu póki co nic nie zastąpi człowieka, który zweryfikuje wygenerowane treści i sprawdzi ich poprawność merytoryczną. Powstaje jednak pytanie, czy w związku z tym zweryfikowane treści muszą być oznaczane jako wygenerowane przez AI. Weryfikacja jest wszakże równoznaczna z aktem przyjęcia odpowiedzialności za takie treści.

Jak korzystamy z generatywnej AI w praktyce?

W praktyce stosunkowo mało prawdopodobne jest, abyśmy korzystali z wyników działania systemu generatywnej AI bez jakiejkolwiek ingerencji w wytworzoną treść (o ile treściami będą teksty – inaczej przedstawia się sytuacja, gdy treściami są grafiki lub wideo).

Zwykle dużo częstsza będzie sytuacja, że otrzymane wyniki poddamy szeregu zmianom i modyfikacji. Możliwe jest, że treści wygenerowane przez system generatywnej AI potraktujemy wręcz jako inspirację, pierwszy projekt, który następnie gruntownie przerobimy dla naszych potrzeb.

Czy w takim przypadku rzeczywiście powinniśmy informować o wykorzystaniu narzędzi sztucznej inteligencji?

Kto jest autorem?

Nie ulega wątpliwości, że w zdecydowanej większości przypadków „surowe” treści wygenerowane przez generatywną AI nie stanowią utworu w rozumieniu prawa autorskiego (z zastrzeżeniem, że istotny wkład człowieka w proces kształtowania takiej treści w ramach kolejnych promptów może zmienić takie założenie).

Jednak, jeśli takie treści będą wstępnym materiałem do przygotowania finalnego dokumentu i zostaną poddane istotnemu przetworzeniu przez autora – człowieka, to ostateczny wynik takiej pracy powinien być traktowany w mojej ocenie jako utwór chroniony przez prawo autorskie.

Inaczej mówiąc – jeśli człowiek wykorzystuje do tworzenia utworów system generatywnej AI jako jeden z elementów procesu twórczego, powstaną utwory. Jeśli wygenerowane przez system AI treści traktujemy jako końcowy rezultat danego procesu i nie poddajemy ich istotnym zmianom, to utwór nie powstanie.

W praktyce rozróżnienie pomiędzy tymi sytuacjami będzie trudne i będzie to rola orzecznictwa sadowego.

Rozróżnienie to będzie miało jednak istotny wpływ na odpowiedź na tytułowe pytanie.

A więc – czy trzeba informować o korzystaniu z AI?

Jeśli w wyniku korzystania z systemów generatywnej AI powstanie utwór (czyli system AI był jedynie narzędziem w procesie twórczym), to według mnie nie ma potrzeby informowania o tym, że w procesie jego powstania wykorzystano system AI (podobnie jak nie informujemy, przy pomocy jakich narzędzi zbieramy informacje opisane w utworze i że to była wyszukiwarka internetowa wykorzystująca AI). Powstanie utworu wiąże się zazwyczaj także z weryfikacją wykorzystanych do jego powstania „surowców”.

Jeśli jednak utwór nie powstaje (gdyż wykorzystywane są „surowe” treści wygenerowane przez system), to odbiorcę tych treści powinniśmy poinformować o wykorzystaniu AI, gdyż:

- treści te mogły zostać niezweryfikowane pod kątem ich prawdziwości, a odbiorca nie będzie się tego spodziewał nie wiedząc o sposobie wytworzenia tekstu,

- odbiorca tych treści może potrzebować tych treści w celu realizacji umowy, w ramach której zobowiązał się do przeniesienia autorskich praw majątkowych do takich treści lub składa oświadczenie o przysługiwaniu mu do tych treści praw autorskich.

Czy system do wykrywania tekstów generowanych przez ChatGPT to system AI wysokiego ryzyka?

Czy system do wykrywania tekstów generowanych przez ChatGPT to system AI wysokiego ryzyka?