Unijny Akt w sprawie sztucznej inteligencji (AI Act) to regulacja, która ma na celu uporządkowanie rozwoju i stosowania systemów sztucznej inteligencji w Unii Europejskiej. Jednym z głównych założeń rozporządzenia jest zróżnicowane podejście do różnych kategorii systemów AI, zależne od poziomu ryzyka, jakie mogą one stwarzać.

W tym artykule, na podstawie danych dotyczących struktury przepisów AI Act, wykazuję, że regulacje AI Act koncentrują się przede wszystkim na systemach AI wysokiego ryzyka, podczas gdy inne kategorie systemów AI są regulowane w dużo mniejszym stopniu.

Dane dotyczące struktury AI Act

Poniższa tabela zawiera dane dotyczące liczby artykułów, punktów preambuły oraz łącznej liczby przepisów dla każdej kategorii systemów AI w AI Act:

Artykuły to główna treść rozporządzenia, określająca konkretne obowiązki i wymogi. Motywy to punkty preambuły, które wyjaśniają cel wprowadzania poszczególnych regulacji. Przepisy administracyjne to artykuły lub motywy, które dotyczą procedur, organów nadzorczych, kar lub kwestii związanych z wejściem w życie AI Act, a zatem nie regulują bezpośrednio samych systemów AI.

Ile systemów AI wysokiego ryzyka jest w systemach AI?

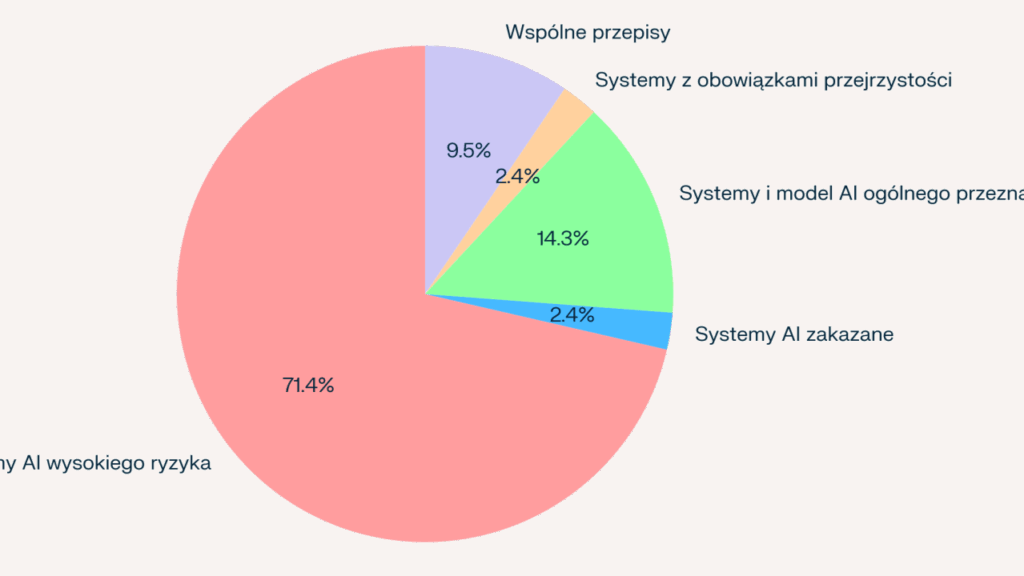

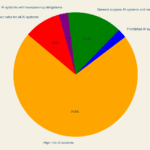

Aby dowieść, że AI Act reguluje głównie systemy AI wysokiego ryzyka, porównajmy liczbę artykułów, czyli wiążących przepisów prawnych, dedykowanych poszczególnym kategoriom systemów AI.

Z wykresu jasno wynika, że zdecydowanie najwięcej przepisów AI Act dotyczy systemów AI wysokiego ryzyka – aż 30. Dla porównania:

- Systemy AI zakazane: 1 artykuł,

- Systemy i model AI ogólnego przeznaczenia: 6 artykułów,

- Systemy z obowiązkami przejrzystości: 1 artykuł,

- Wspólne przepisy: 4 artykuły.

Ta dysproporcja jasno pokazuje, że AI Act kładzie szczególny nacisk na regulację systemów AI wysokiego ryzyka.

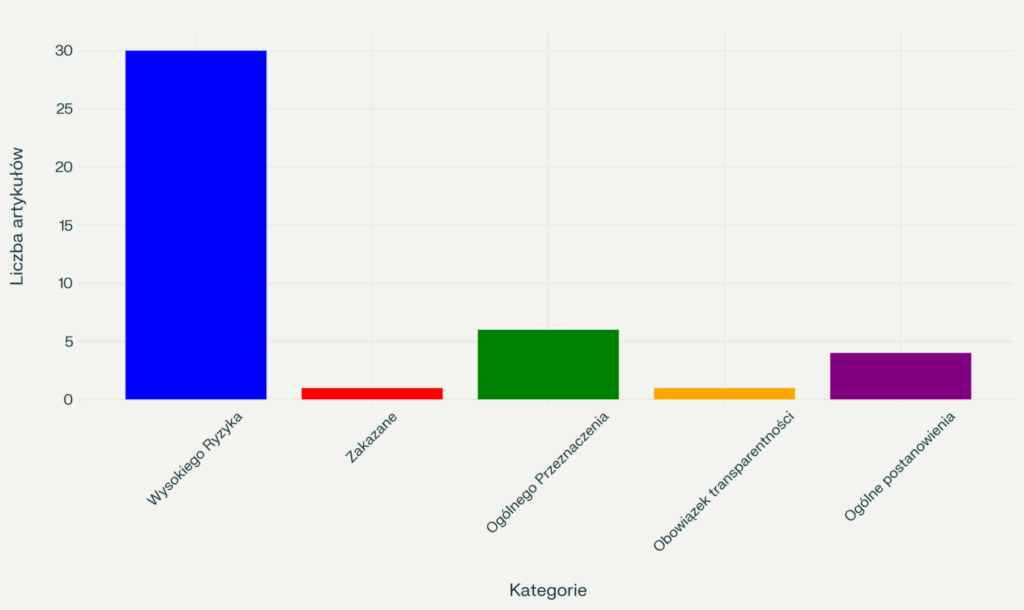

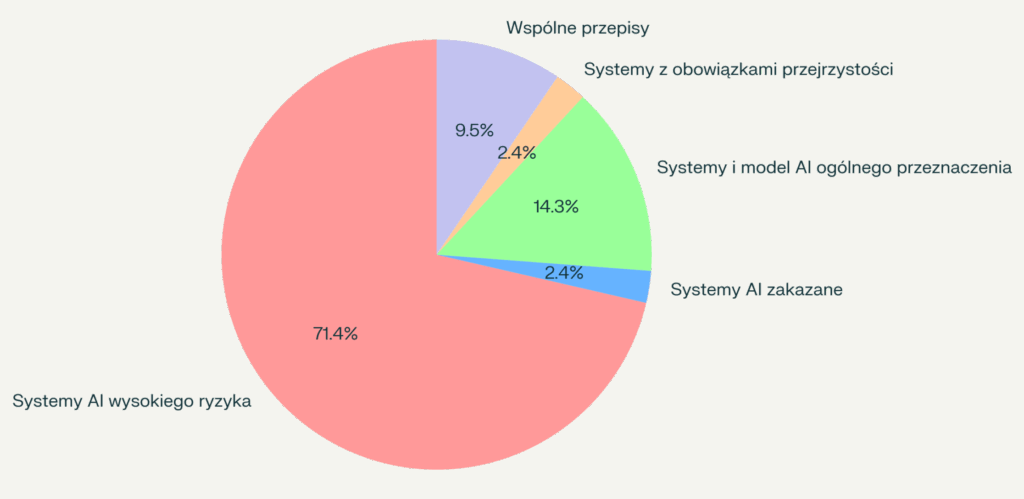

Aby jeszcze lepiej zilustrować dominację przepisów dotyczących systemów AI wysokiego ryzyka, warto pokazać to na wykresie kołowym.

Łączna liczba artykułów dla kategorii bezpośrednio regulujących systemy AI (wysokiego ryzyka, zabronione, ogólnego przeznaczenia, z obowiązkiem przejrzystości, przepisy wspólne)) wynosi 42. Udział procentowy każdej kategorii przedstawia się zatem następująco:

- Systemy AI wysokiego ryzyka: 71,4%,

- Systemy AI zakazane: 2,4%,

- Systemy i modele AI ogólnego przeznaczenia: 14,3%,

- Systemy z obowiązkami przejrzystości: 2,4%,

- Wspólne przepisy: 9,5%.

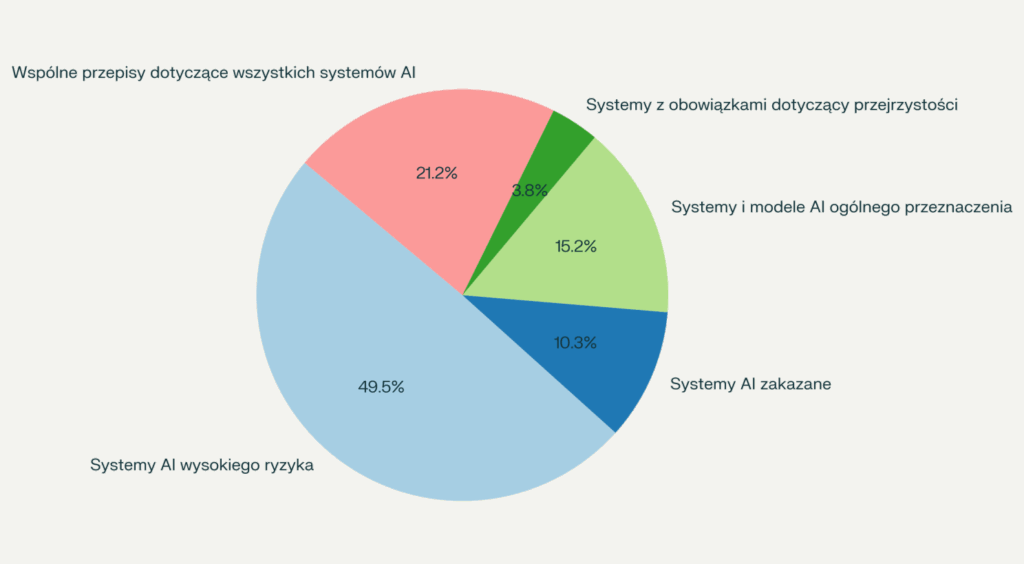

Dla porównania warto jeszcze spojrzeć na wykres uwzględniający nie tylko same przepisy, ale i liczbę motywów preambuły dedykowanych poszczególnym rodzajów systemów AI. Także i tu widać, że systemom AI wysokiego ryzyka AI Act poświęca niemal połowę postanowień.

Interpretacja wyników

Dlaczego AI Act tak mocno koncentruje się na systemach wysokiego ryzyka?

Systemy te, wykorzystywane, między innymi, w ochronie zdrowia, rekrutacji, edukacji, świadczeniu podstawowych usług publicznych czy egzekwowaniu prawa, mogą znacząco wpływać na życie ludzi i funkcjonowanie społeczeństwa. Dlatego wymagają szczegółowych przepisów zapewniających ich bezpieczeństwo i zgodność z prawami podstawowymi.

Inne kategorie systemów AI są regulowane w dużo mniejszym stopniu:

- Systemy AI zakazane: W AI Act jest tylko jeden przepis (art. 5) zakazujący stosowania systemów AI uznanych za nieakceptowalne.

- Systemy (i modele) ogólnego przeznaczenia: 6 artykułów odzwierciedla umiarkowane podejście regulacyjne do systemów, które mogą być używane w różnych kontekstach, ale niekoniecznie same z siebie stwarzają wysokie ryzyko.

- Systemy AI z obowiązkiem przejrzystości: Jeden artykuł (art. 50) definiuje podstawowe wymogi przejrzystości w odniesieniu do 5 różnych kontekstów stosowania systemów AI.

Wnioski

Proste porównanie liczby przepisów AI Act jasno wskazuje, że AI Act reguluje głównie systemy AI wysokiego ryzyka, co znajduje odzwierciedlenie w liczbie dedykowanych im przepisów (30) i ich udziale procentowym (ponad 71%) wśród przepisów dotyczących systemów AI. Pozostałe kategorie systemów AI są regulowane w znacznie mniejszym stopniu.

Nie jest zatem uzasadniona teza, że AI Act to regulacja hamująca rozwój systemów AI w Europie i konkurencyjność unijnych dostawców takich systemów. AI Act przyhamowuje jedynie rozwój tych systemów AI, z których wykorzystywaniem wiążą się istotne ryzyka dla zdrowia, bezpieczeństwa lub praw podstawowych. I w mojej ocenie to dobrze.

Inne kategorie systemów AI – dominujące w praktyce – są regulowane albo w niewielkim stopniu albo wcale. I to także dobrze.

The AI Act Primarily Regulates High-Risk AI Systems

The AI Act Primarily Regulates High-Risk AI Systems